Llama 3 は、Meta の最新の大規模言語モデルです。質問の解決、学校の宿題やプロジェクトのサポートなど、さまざまな目的に使用できます。Llama 3 を Windows 11 マシンにローカルに展開すると、インターネットにアクセスできなくてもいつでも使用できるようになります。この記事では、 Windows 11 PC に Llama 3 をインストールする方法 。

Windows 11 PC に Llama 3 をインストールする方法

Python を使用して Windows 11 PC に Llama 3 をインストールするには、技術的なスキルと知識が必要です。ただし、いくつかの代替方法を使用すると、Windows 11 マシンに Llama 3 をローカルに展開できます。これらの方法を紹介します。

Windows 11 PC に Llama 3 をインストールするには、コマンド プロンプトでいくつかのコマンドを実行する必要があります。ただし、これにより使用できるのはコマンド ライン バージョンのみです。 Web UI を使用する場合は、さらに手順を実行する必要があります。これら両方の方法を紹介します。

CMD 経由で Windows 11 PC に Llama 3 を展開する

Windows 11 PC に Llama 3 を展開するには、Windows マシンに Ollama をインストールする必要があります。同じ手順は次のとおりです。

- 訪問 オラマの公式ウェブサイト 。

- をクリックしてください ダウンロード ボタンをクリックしてから選択します 窓 。

- ここで、 Windows 用のダウンロード ボタンをクリックして exe ファイルを PC に保存します。

- exe ファイルを実行して、マシンに Ollama をインストールします。

Ollama がデバイスにインストールされたら、コンピューターを再起動します。バックグラウンドで実行されているはずです。システムトレイに表示されます。ここで、Ollama Web サイトの [モデル] オプションをクリックします。さまざまなモデルが表示されます。

リセット、つまり設定

Llama 3.1 は、次の 3 つのパラメータで使用できます。

- 8B

- 70B

- 405B

最後のパラメータは最大のパラメータであり、明らかにローエンド PC では実行できません。 Llama 3.2 には次の 2 つのパラメータがあります。

- 1B

- 3B

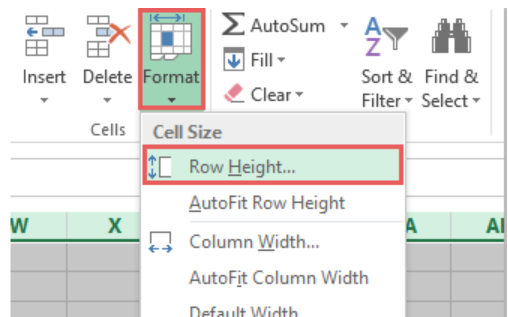

PC にインストールする Llama バージョンをクリックします。たとえば、Llama 3.2 をインストールする場合は、[Llama 3.2] をクリックします。ドロップダウンで、インストールするパラメータを選択できます。その後、その隣にあるコマンドをコピーし、コマンド プロンプトに貼り付けます。

便宜上、Llama 3.2 モデル用に両方のコマンドを作成しました。 Llama 3.2 3B モデルをインストールするには、次のコマンドを実行します。

ollama run llama3.2:3b

Llama 3.2 1B モデルをインストールするには、次のコマンドを使用します。

ollama run llama3.2:1b

システムの復元ウィンドウ10を中断するとどうなりますか

コマンド プロンプトを開き、上記のコマンドのいずれかを (要件に基づいて) 入力し、キーを押します。 入力 。必要なファイルのダウンロードには時間がかかります。ダウンロード時間はインターネット接続速度によっても異なります。完了後、次の画面が表示されます。 成功 コマンドプロンプトのメッセージ。

次に、Llama 3.2 モデルを使用するためのメッセージを入力します。 Llama 3.1 モデルをインストールする場合は、Ollama Web サイトで入手可能なコマンドを使用します。

次回コマンド プロンプトを起動するときは、同じコマンドを使用して PC 上で Llama 3.1 または 3.2 を実行します。

CMD を介して Llama 3 をインストールする場合、欠点が 1 つあります。チャット履歴は保存されません。ただし、ローカル ホストにデプロイすると、チャット履歴が保存され、より良いユーザー インターフェイスが得られます。次のメソッドは、その方法を示しています。

Windows 11 に Llama 3 Web UI を展開する

Web ブラウザーで Llama 3 を使用すると、CMD ウィンドウで使用する場合と比較して、より優れたユーザー インターフェイスが提供され、チャット履歴も保存されます。 Web ブラウザに Llama 3 を導入する方法を説明します。

Web ブラウザで Llama 3 を使用するには、Llama 3 から Ollama および Docker までがシステムにインストールされている必要があります。 Llama 3 をまだインストールしていない場合は、(上で説明したように) Ollama を使用してインストールします。ここで、Docker をダウンロードしてインストールします。 公式ウェブサイト 。

Docker をインストールしたら、Docker を起動し、サインアップしてアカウントを作成します。 Docker はサインアップするまで実行されません。サインアップしたら、Docker アプリでアカウントにサインインします。 Docker をシステム トレイに最小化します。 Docker アプリと Ollama アプリはバックグラウンドで実行されている必要があります。そうしないと、Web ブラウザで Llama 3 を使用できません。

次に、コマンド プロンプトを開き、次のコマンドをコピーして、コマンド プロンプトに貼り付けます。

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

上記のコマンドでは、必要なリソースをダウンロードするのに時間がかかります。したがって、ある程度の忍耐力を持ってください。コマンドの完了後、Docker を開き、 コンテナ 左側から見た部分。コンテナがポート 3000:8080 で自動的に作成されていることがわかります。

システムリカバリディスクウィンドウを作成する10

ポート 3000:8080 をクリックします。これにより、デフォルトの Web ブラウザで新しいタブが開きます。次に、サインアップしてサインインし、Web ブラウザーで Llama 3 を使用します。アドレスバーを見ると、次のようになります。 ローカルホスト:3000 これは、Llama 3 がコンピューター上でローカルにホストされていることを意味します。インターネット接続がなくても使用できます。

ドロップダウンから Llama チャット モデルを選択します。 Llama 3 のチャット モデルをさらに追加したい場合は、必要なコマンドを使用して Ollama 経由でインストールする必要があります。その後、モデルは Web ブラウザで自動的に利用できるようになります。

すべてのチャット履歴が保存され、左側からアクセスできます。終了する場合は、Web ブラウザでセッションをログアウトします。その後、Docker アプリを開き、 停止 Dockerを停止するボタン。これで、Docker を閉じることができます。

次回、Web ブラウザで Llama 3 を使用する場合は、Ollama と Docker を起動し、数分待ってから、Docker コンテナ内のポートをクリックして Web ブラウザで localhost サーバーを開きます。次に、アカウントにサインインして、Llama 3 の使用を開始します。

これがお役に立てば幸いです。

Llama 3 は Windows 上で実行できますか?

コンピュータのハードウェア構成に応じて、システム上で Llama 3 を実行できます。 1Bモデルは最軽量です。コマンド プロンプトを介してシステムにインストールして実行できます。

Llama 3 にはどれくらいの RAM が必要ですか?

Llama 3 の最軽量モデルは Llama 3.2 1B です。 Llama 3.2 1B モデルを実行するには、システムに 16 GB の RAM が必要です。これに加えて、システムには強力な GPU も搭載されている必要があります。 Llama 3 の上位モデルでは、より多くのシステム リソースが必要になります。

次に読む : レオナルド・フェニックスAIの使い方 。